Ein hervorragender Insider Kommentar zu Gebru und Mitchell, der Frau die von Google wegen ihres AI Papers gefeuert wurde.

Michaela Menken schreibt dazu

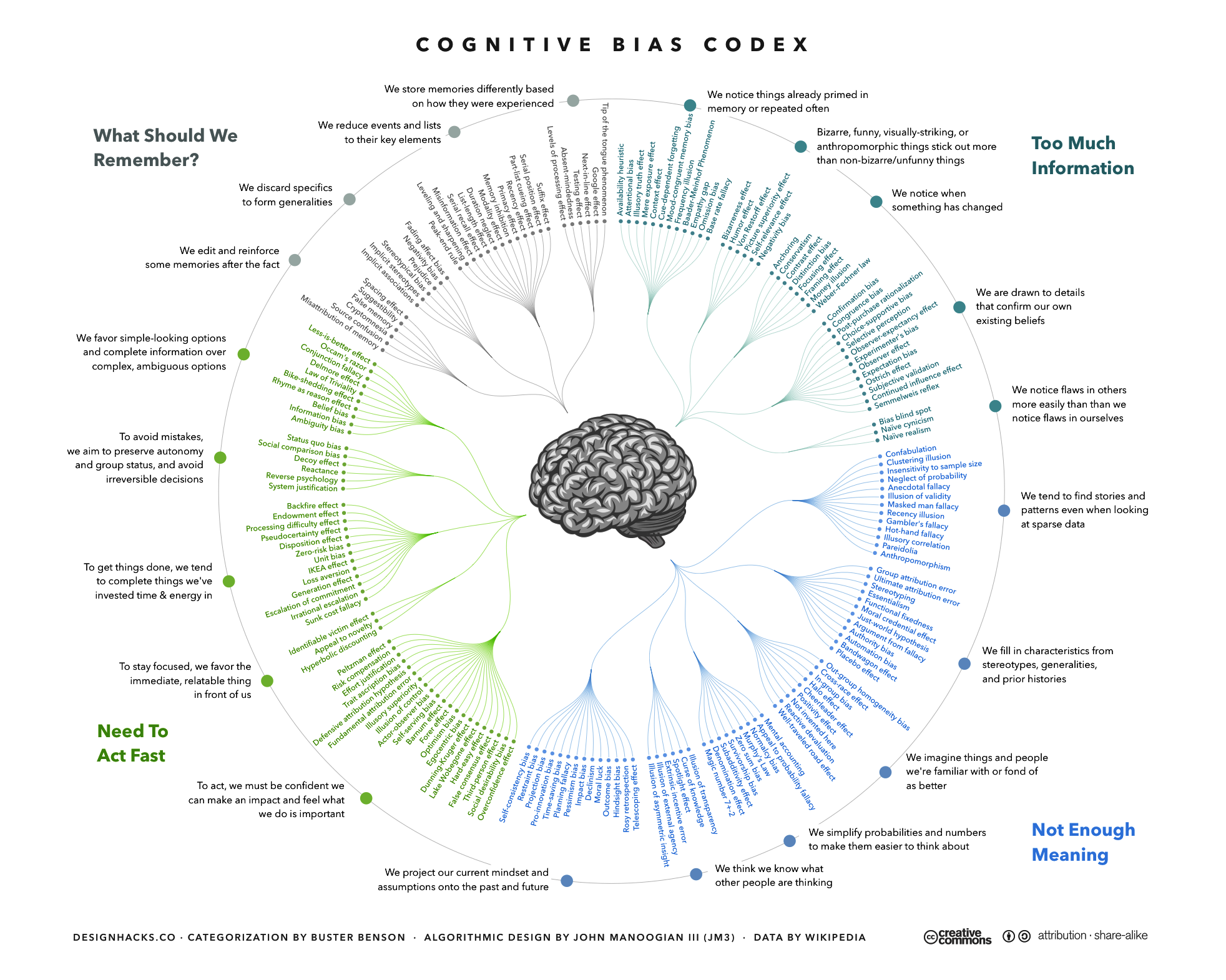

Bias in/bias out. Sprich, die gelernten Modelle verstärken die Positionen und Stimmen, die in den Trainingsdaten am meisten vertreten sind. Und das sind selten die Positionen und Stimmen von Minderheiten …

Reporting Bias … implizite, ontologische Kenntnis der Welt steht der KI nicht vollumfänglich zur Verfügung…

Selection Bias also … die durch die Auswahl der Daten entstehen können…

Confirmation Bias … ob der Output für qualitativ gut oder schlecht gehalten wird, korrespondiert natürlich mit dem Weltbild und den Erwartungen desjenigen, der die Überprüfung durchführt.

Automation Bias. Menschen neigen dazu, Ergebnisse, die algorithmisch herbeigeführt wurden, schneller und leichter anzunehmen

Es sind also massive ethische Probleme, die mit dem Einzug der KI entstehen. Nicht umsonst wurde in Augsburg im letzten Jahr ein “Center for Responsible AI Technologies” gegründet. Dazu wurden 100 neue Lehrstühle geschaffen, selbst der bayrische Ethikrat hat sich vor 2 Wochen einschlägig wenn auch wenig konkret dazu geäussert.